No mundo da inteligência artificial, modelos de linguagem de larga escala (LLMs) estão cada vez mais presentes em diversas aplicações. No entanto, o viés de posição nesses modelos pode impactar significativamente a precisão das respostas, especialmente em tarefas críticas. Recentemente, uma pesquisa conduzida pelo MIT revelou que o viés de posição desses modelos, uma tendência a privilegiar dados no início ou fim de sequências textuais, pode ser influenciado por fatores arquiteturais e pelos dados de treinamento. Esse problema, que aparece em tarefas de recuperação de informação, apresenta um padrão em forma de U: maior precisão no início, diminuição no meio e um leve aumento no final.

A Importância das Arquiteturas de Transformadores

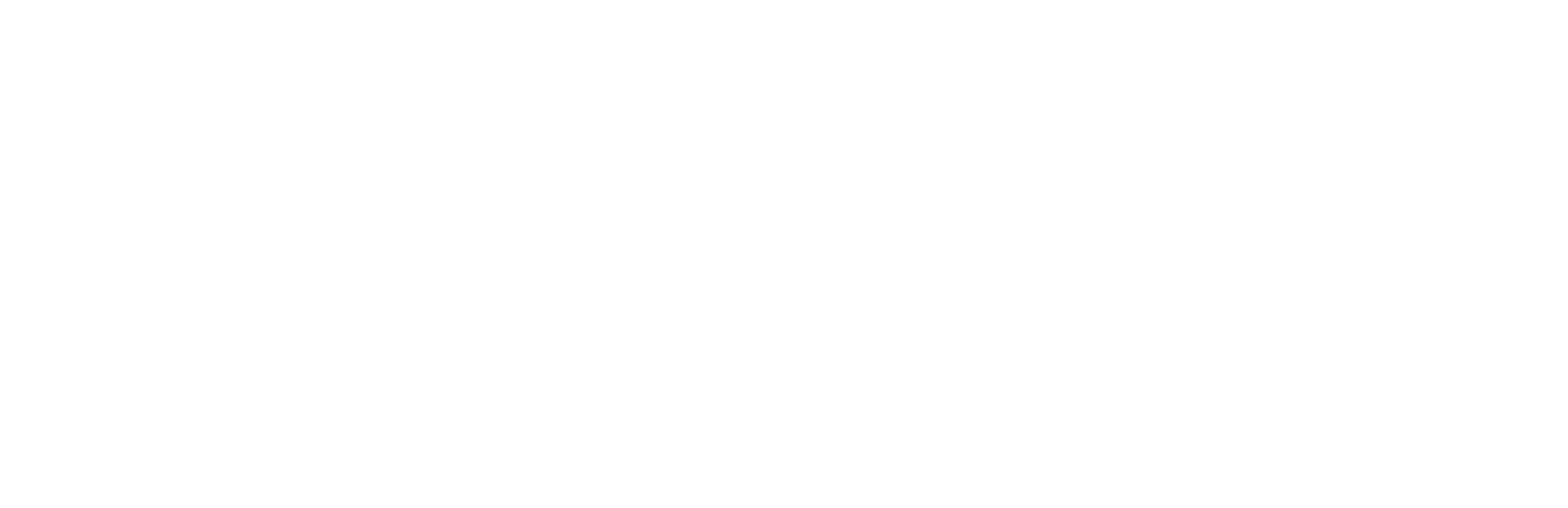

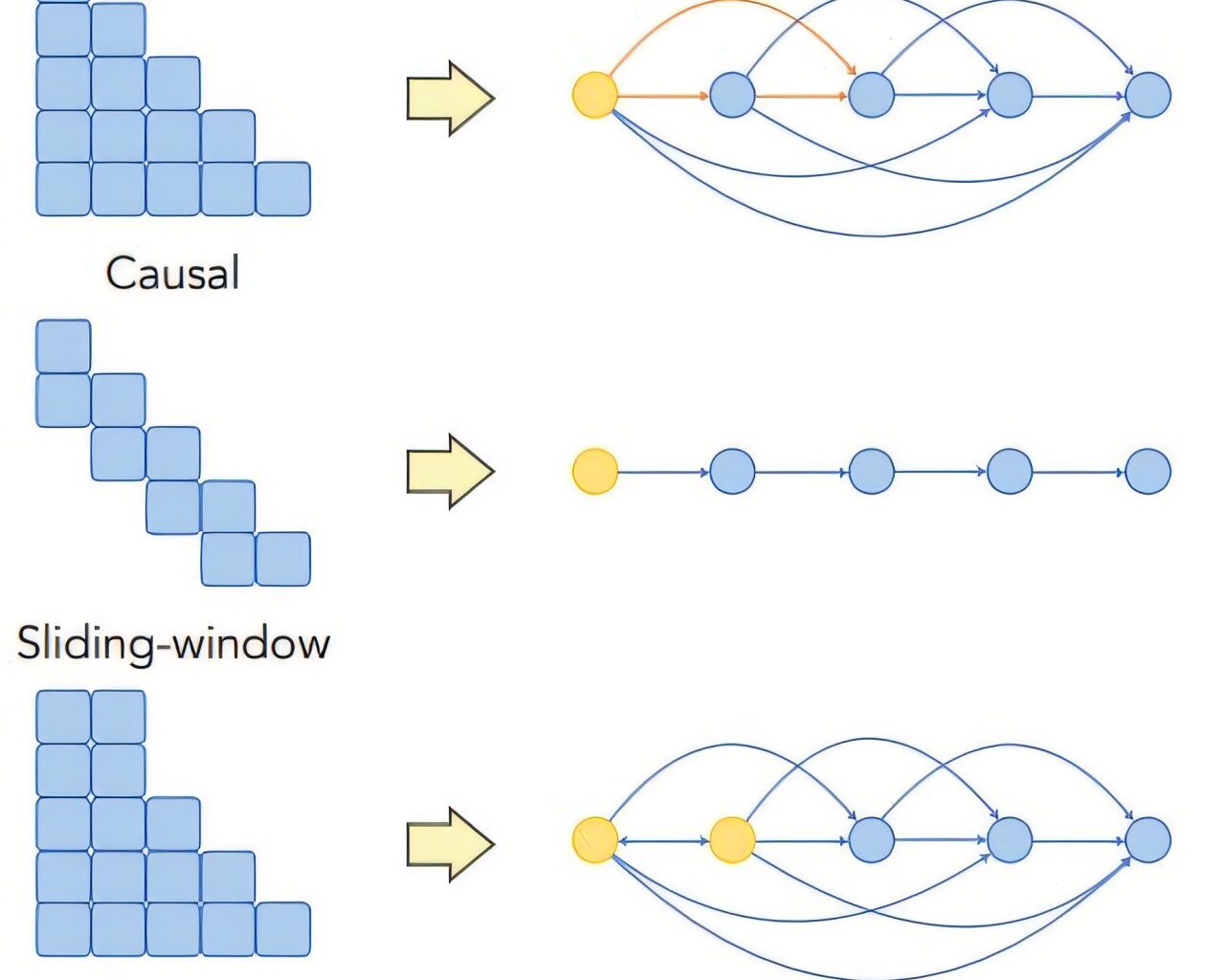

Os modelos transformers, essenciais para o funcionamento dos LLMs, utilizam um mecanismo de atenção que ajuda a destacar certas partes do texto durante o processamento. No entanto, esse mecanismo pode contribuir para o viés de posição observado. Além disso, o uso das chamadas máscaras causais é outro fator que pode influenciar como a informação é priorizada ao longo de uma sequência de texto. Com essas arquiteturas em destaque, é crucial desenvolver estratégias que mitiguem tais impactos.

Stakeholders Envolvidos e o Impacto no Mercado

A pesquisa realizada pelo MIT, com a liderança de Xinyi Wu e contando com comentários de profissionais como Amin Saberi de Stanford, enfatiza a necessidade de entendimento e correção desse viés para aplicações de alto risco, como jurídico e saúde. A utilização de LLMs por empresas gigantes como OpenAI, Google e Microsoft coloca em voga a necessidade urgente de essas empresas ajustarem seus modelos para aumentar a confiabilidade e precisão.

Metodologias Propostas e Desafios Técnicos

A pesquisa sugere que alterações no mecanismo de atenção, utilização de diferentes técnicas de masking, e melhorias em codificadores posicionais podem ser caminhos viáveis para mitigar o viés de posição. Contudo, ajustar arquiteturas já implantadas em larga escala não é simples e pode envolver trade-offs que afetem outros aspectos de desempenho dos modelos. Essa complexidade técnica precisa ser cuidadosamente manejada para não comprometer a eficácia dos LLMs em outros contextos.

Impactos Econômicos e Sociais

A confiabilidade dos LLMs diretamente impacta os custos e a eficácia operacional de empresas em setores sensíveis. Erros provenientes do viés de posição podem chamar a atenção para a necessidade de revisões manuais, aumentando custos e reduzindo eficiência. Socialmente, um modelo mais preciso ajuda a garantir justiça e equidade em sistemas automatizados que afetam tomada de decisões em larga escala, como na saúde e na justiça.

Oportunidades de Inovação e Regulamentações

Diante da crescente preocupação com a explicabilidade e transparência da IA, surgem oportunidades para empresas se destacarem ao desenvolver soluções que abordem o viés de posição. As regulamentações, como a AI Act da União Europeia, estão se voltando para garantir IA mais confiáveis e essas regulamentações podem impulsionar pesquisas e inovações que ajudam a criar modelos mais robustos.

Reflexão do Time do Blog da Engenharia

- É crucial que engenheiros de IA entendam e trabalhem para mitigar vieses potencialmente prejudiciais nos modelos, garantindo aplicações mais éticas e eficazes.

- A integração de novas técnicas nos atuais pipelines de transformação pode oferecer um diferencial competitivo significativo no mercado, especialmente para aplicações longas e complexas.

- O avanço em tecnologias de atenção deve ser acompanhado de perto, dado seu potencial para transformar a acuracidade e aplicabilidade dos LLMs em várias indústrias.

Via: https://techxplore.com/news/2025-06-lost-middle-llm-architecture-ai.html